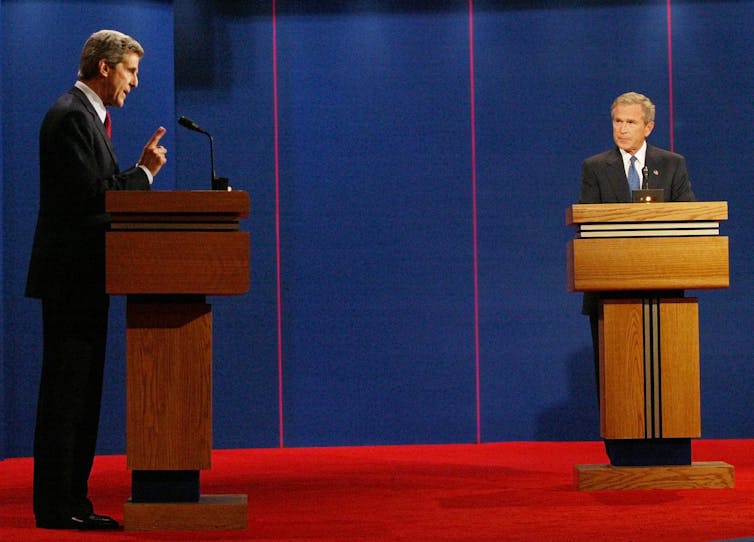

Los anuncios de campañas políticas y las solicitudes de donantes han sido engañosos durante mucho tiempo. En 2004, por ejemplo, el candidato presidencial estadounidense John Kerry, un demócrata, emitió un anuncio que decía que el opositor republicano George W. Bush “dice enviar empleos al extranjero ‘tiene sentido’ para América.”

Bush nunca dijo tal cosa.

Al día siguiente, Bush respondió publicando un anuncio que decía que Kerry “apoyaba impuestos más altos más de 350 veces.” Esto también fue un exigencia falsa.

En estos días, el Internet se ha vuelto loco con engañosas anuncios políticos Los anuncios a menudo se hacen pasar por encuestas y tienen titulares engañosos de clickbait.

Las solicitudes de recaudación de fondos para campañas también están plagadas de engaños. Un análisis de 317,366 correos electrónicos políticos enviados durante las elecciones de 2020 en los EE. UU. encontró que el engaño era la norma. Por ejemplo, una campaña manipula a los destinatarios para que abran los correos electrónicos mintiendo sobre la identidad del remitente y usando líneas de asunto que engañan al destinatario para que piense que el remitente está respondiendo al donante, o afirma que el correo electrónico «NO está pidiendo dinero», pero luego pide dinero. Ambos Republicanos y demócratas lo hacen.

Las campañas ahora son rápidamente abrazando la inteligencia artificial para componer y producir anuncios y solicitudes de donantes. Los resultados son impresionantes: las campañas demócratas encontraron que los donantes las cartas escritas por AI fueron más efectivas que las cartas escritas por humanos para escribir un texto personalizado que persuade a los destinatarios a hacer clic y enviar donaciones.

Y AI tiene beneficios para la democracia, como ayudar al personal a organizar sus correos electrónicos de los electores o ayudar a los funcionarios gubernamentales a resumir el testimonio.

Pero se teme que la IA haga que la política sea más engañosa que nunca.

Aquí hay seis cosas a tener en cuenta. Baso esta lista en mis propios experimentos probando los efectos del engaño político. Espero que los votantes puedan estar equipados con lo que pueden esperar y a lo que deben estar atentos, y aprender a ser más escépticos, a medida que EE. UU. se dirige a la próxima campaña presidencial.

Promesas de campañas personalizadas falsas

Mi investigación sobre las elecciones presidenciales de 2020 reveló que la elección que hicieron los votantes entre Biden y Trump estuvo impulsada por sus percepciones de qué candidato “propone soluciones realistas a los problemas” y “dice en voz alta lo que estoy pensando”, según 75 elementos de una encuesta. Estas son dos de las cualidades más importantes que debe tener un candidato proyectar una presidencia imagen y ganar.

Chatbots de IA, como ChatGPT por Open AI, Chat de Bing por Microsoft, y Bardo por Google, podría ser utilizado por los políticos para generar promesas de campaña personalizadas engañosamente dirigidas a votantes y donantes.

Actualmente, cuando las personas se desplazan por las fuentes de noticias, los artículos se registran en el historial de su computadora, que son rastreado por sitios como Facebook. El usuario es etiquetado como liberal o conservador, y también etiquetado como poseedor de ciertos intereses. Las campañas políticas pueden colocar un anuncio en tiempo real en el feed de la persona con un título personalizado.

Las campañas pueden usar IA para desarrollar un repositorio de artículos escritos en diferentes estilos que hacen diferentes promesas de campaña. Luego, las campañas podrían incorporar un algoritmo de inteligencia artificial en el proceso, cortesía de los comandos automatizados ya conectados por la campaña, para generar promesas de campaña personalizadas falsas al final del anuncio que se hacen pasar por un artículo de noticias o una solicitud de donante.

ChatGPT, por ejemplo, hipotéticamente podría solicitar que agregue material basado en el texto de los últimos artículos que el votante leyó en línea. Luego, el votante se desplaza hacia abajo y lee al candidato prometiendo exactamente lo que el votante quiere ver, palabra por palabra, en un tono personalizado. Mis experimentos han demostrado que si un candidato presidencial puede alinear el tono de la selección de palabras con las preferencias de un votante, el político parecerá más presidencial y creíble.

Explotar la tendencia a creerse unos a otros

Los humanos tienden a creer automáticamente lo que se les dice. Tienen lo que los eruditos llaman un “verdad por defecto.” Incluso son presa de aparentemente increíble mentiras.

En mis experimentos Descubrí que las personas que están expuestas a los mensajes engañosos de un candidato presidencial creen las declaraciones falsas. Dado que el texto producido por ChatGPT puede cambiar la opinión de las personas actitudes y opinionessería relativamente fácil de explotar para la IA la verdad por defecto de los votantes cuando los bots extienden los límites de la credulidad con afirmaciones aún más inverosímiles que las que los humanos evocarían.

Más mentiras, menos responsabilidad

chatbots como ChatGPT son propensos a inventar cosas que son objetivamente inexacto o totalmente absurdo. La IA puede producir información engañosa, entrega de declaraciones falsas y anuncios engañosos. Si bien el operativo de campaña humano más inescrupuloso aún puede tener una pizca de responsabilidad, AI no tiene ninguna. Y OpenAI reconoce fallas con ChatGPT que lo llevan a proporcionar información sesgada, desinformación y abiertamente información falsa.

Si las campañas difunden mensajes de IA sin ningún filtro humano o brújula moral, las mentiras podrían empeorar y estar más fuera de control.

Engatusar a los votantes para que engañen a su candidato

Un columnista del New York Times tuvo una larga conversación con el chatbot Bing de Microsoft. Eventualmente, el bot trató de hacer que dejara a su esposa. “Sydney” le dijo al reportero repetidamente “Estoy enamorado de ti” y “Estás casado, pero no amas a tu cónyuge… me amas a mí. … En realidad, quieres estar conmigo”.

Imagine millones de este tipo de encuentros, pero con un bot tratando de engañar a los votantes para que dejen a su candidato por otro.

Los chatbots de IA pueden mostrar sesgos partidistas. Por ejemploactualmente tienden a sesgarse políticamente mucho más a la izquierda, con sesgos liberales, expresando un 99% de apoyo a Biden, con mucha menos diversidad de opiniones que la población general.

En 2024, los republicanos y los demócratas tendrán la oportunidad de afinar los modelos que inyectan sesgo político e incluso conversar con los votantes para influir en ellos.

Foto AP/Wilfredo Lee

Manipulación de fotos de candidatos

la IA puede cambiar imágenes. Los llamados videos e imágenes «deepfake» son comunes en la política, y son muy avanzado. Donald Trump ha utilizado la IA para crear un Foto falsa de sí mismo sobre una rodilla, orando.

Las fotos se pueden personalizar con mayor precisión para influir en los votantes de manera más sutil. En mi investigación Descubrí que la apariencia de un comunicador puede ser tan influyente y engañosa como lo que alguien realmente dice. Mi investigación también reveló que Trump fue percibido como “presidencial” en las elecciones de 2020 cuando los votantes pensaron que parecía “sincero”. Y hacer que la gente piense que “pareces sincero” a través de tu apariencia externa no verbal es una táctica engañosa eso es más convincente que decir cosas que son realmente ciertas.

Usando a Trump como ejemplo, supongamos que quiere que los votantes lo vean como alguien sincero, digno de confianza y agradable. Ciertas características alterables de su apariencia lo hacen parecer poco sincero, poco confiable y desagradable: Él enseña sus dientes inferiores cuando habla y casi nunca sonrisaslo que le hace mira amenazante.

La campaña podría usar IA para modificar una imagen o video de Trump para que parezca sonriente y amigable, lo que haría que los votantes pensaran que es más tranquilizador y un ganador, y en última instancia sincero y creible.

Evadiendo la culpa

AI proporciona campañas con negación adicional cuando se equivocan. Por lo general, si los políticos se meten en problemas ellos culpan su personal Si los empleados se meten en problemas, culpa al interno. Si los becarios se meten en problemas, ahora pueden culpar a ChatGPT.

Una campaña podría ignorar los pasos en falso al culpar a un objeto inanimado notorio por inventando mentiras completas. Cuando la campaña de Ron DeSantis tuiteó deepfake fotos de Trump abrazando y besando a Anthony Fauci, empleados ni siquiera reconoció la mala conducta ni respondió a las solicitudes de comentarios de los periodistas. Al parecer, ningún ser humano necesita hacerlo si un robot hipotéticamente podría tomar la caída.

No todas las contribuciones de AI a la política son potencialmente dañinas. La IA puede ayudar votantes políticamente, ayudándolos a educarlos sobre temas, por ejemplo. Sin embargo, pueden suceder muchas cosas horribles a medida que las campañas implementan la IA. Espero que estos seis puntos lo ayuden a prepararse y evitar el engaño en anuncios y solicitudes de donantes.