Facebook ha anunciado nuevas herramientas para evitar compartir imágenes, videos y cualquier otro contenido que incluya material de abuso sexual infantil (CSAM) en su plataforma. Por un lado, advertirá a los usuarios cuando estén compartiendo imágenes que podrían contener material CSAM potencial. En segundo lugar, evitará que los usuarios busquen dicho contenido en su plataforma con una nueva notificación.

Mientras que el primero está dirigido a aquellos que podrían estar compartiendo este contenido con una intención no maliciosa, y el segundo está dirigido a aquellos que buscan dicho contenido en Facebook con planes de consumir este contenido o usarlo con fines comerciales.

“No permitimos casos de abuso sexual infantil o el uso de nuestra plataforma para interacciones inapropiadas con menores. De hecho, hacemos un esfuerzo adicional. Digamos que cuando los padres o abuelos a veces comparten imágenes inocentes de sus hijos o nietos en la bañera, no permitimos ese contenido. Queremos asegurarnos de que, dada la naturaleza social de nuestra plataforma, queremos reducir el margen de uso indebido tanto como sea posible ”, explicó Karuna Nain, directora de Política de seguridad global en Facebook durante una llamada de Zoom con los medios.

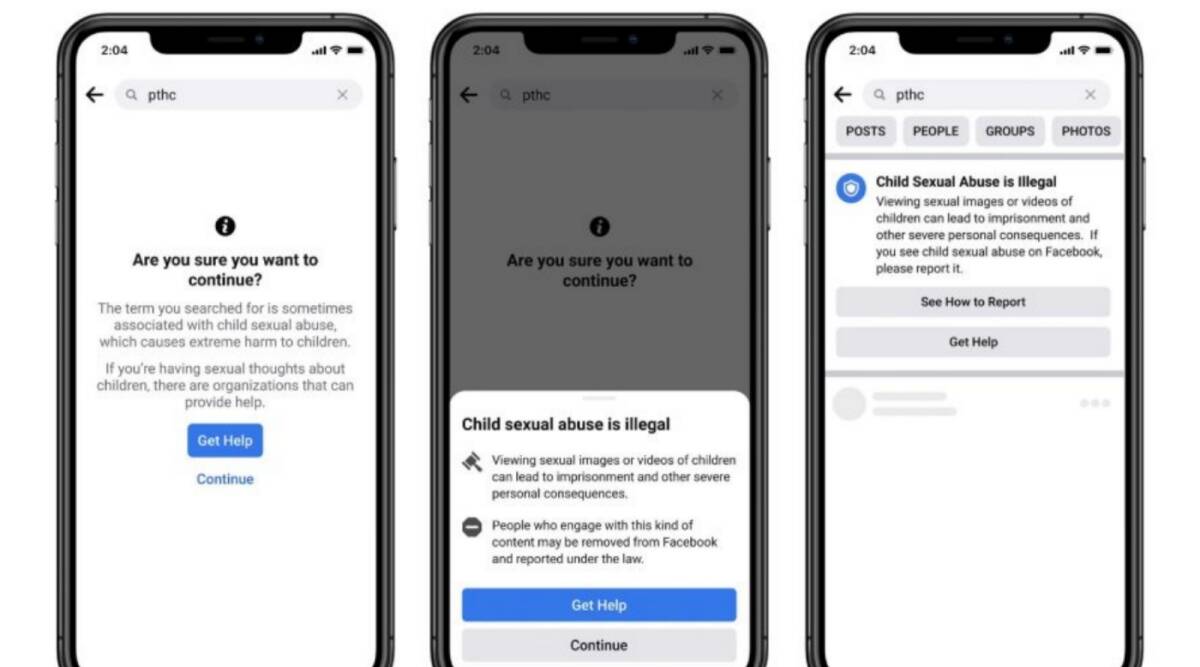

Con las nuevas herramientas, Facebook mostrará una ventana emergente a quienes busquen contenido CSAM ofreciéndoles ayuda de organizaciones de desvío de delincuentes. La ventana emergente también compartirá información sobre las consecuencias de ver contenido ilegal.

El segundo es una alerta de seguridad que informa a las personas cuando están compartiendo cualquier meme viral que contenga contenido de explotación infantil.

La notificación de Facebook advertirá al usuario que compartir dicho contenido puede causar daño y que va en contra de las políticas de la red, agregando que existen consecuencias legales por compartir este material. Esto está dirigido más a aquellos usuarios que no necesariamente comparten el contenido por motivos maliciosos, pero que pueden compartirlo para expresar conmoción o indignación.

Estudio de Facebook sobre contenido CSAM y por qué se comparte

Las herramientas son el resultado del estudio en profundidad de Facebook del contenido de explotación infantil ilegal que informó al Centro Nacional para Niños Desaparecidos y Explotados de EE. UU. (NCMEC) durante los meses de octubre y noviembre de 2020. Se requiere informar el contenido de CSAM antes de ley.

La propia admisión de Facebook mostró que eliminó casi 5,4 millones de piezas de contenido relacionado con el abuso sexual infantil en el cuarto trimestre de 2020. En Instagram, este número fue de 800.000.

Facebook advertirá a los usuarios cuando compartan imágenes que podrían contener material CSAM potencial.

Según Facebook, “más del 90% de este contenido era igual o visualmente similar al contenido reportado anteriormente”, lo cual no es sorprendente dado que muy a menudo el mismo contenido se comparte repetidamente.

El estudio mostró que “copias de solo seis videos fueron responsables de más de la mitad del contenido de explotación infantil” que se informó durante el período octubre-noviembre de 2020.

Para comprender mejor la razón detrás del intercambio de contenido CSAM en la plataforma, Facebook dice que ha trabajado con expertos en explotación infantil, incluido el NCMEC, para desarrollar una taxonomía respaldada por investigaciones para categorizar la aparente intención de una persona detrás de esto.

Con base en esta taxonomía, Facebook evaluó 150 cuentas que fueron reportadas al NCMEC por subir contenido de explotación infantil en julio y agosto de 2020 y enero de 2021. Se estima que más del 75% de estas personas no exhibieron intenciones maliciosas, es decir, no tenían la intención dañar a un niño o obtener ganancias comerciales al compartir el contenido. Muchos estaban expresando indignación o mal humor por la imagen. Pero Facebook advierte que los hallazgos del estudio no deben considerarse una medida precisa del ecosistema de seguridad infantil y el trabajo en este campo aún está en curso.

Al explicar cómo funciona el marco, Nain dijo que tienen cinco categorías amplias para categorizar el contenido cuando se busca un CSAM potencial. Existe la categoría maliciosa obvia, hay dos depósitos que no son maliciosos y uno es un depósito intermedio, donde el contenido tiene el potencial de volverse malicioso pero no estaba 100% claro.

“Una vez que creamos ese marco de intención, tuvimos que sumergirnos un poco. Por ejemplo, en el segmento malicioso habría dos categorías amplias. Uno era preferencial donde prefería o tenía preferencia por este tipo de contenido, y el otro era comercial donde realmente lo hace porque estaba obteniendo algún tipo de ganancia monetaria con él ”, explicó y agregó que el marco es completo y desarrollado con los expertos en este espacio. Este marco también se utiliza para equipar a los revisores humanos para que puedan etiquetar el contenido potencial de CSAM.

¿Cómo se identifica CSAM en Facebook?

Para identificar CSAM, el contenido reportado es hash o marcado y agregado a una base de datos. Los datos ‘hash’ se utilizan en todo el espacio público de Facebook y sus productos. Sin embargo, en productos cifrados de extremo a extremo (E2E) como WhatsApp Messenger o chats secretos en FB Messenger estarían exentos porque Facebook necesita el contenido para compararlo con algo que ya tiene. Esto no es posible en los productos E2E, dado que el contenido no puede ser leído por nadie más que por las partes involucradas.

La compañía afirma que cuando se trata de monitorear de manera proactiva las imágenes de explotación infantil, tiene una calificación de más del 98% tanto en Instagram como en Facebook. Esto significa que el sistema marca esas imágenes por sí solo sin requerir ningún informe en nombre de los usuarios.

“Queremos asegurarnos de tener una tecnología de detección muy sofisticada en este espacio de Protección Infantil. La forma en que funciona el ADN de la foto es que cualquier fotografía se carga en nuestra plataforma, se escanea contra un banco de datos conocido de imágenes hash de abuso infantil, que es mantenido por el NCMEC ”, explicó Nain.

Agregó que la compañía también está utilizando «aprendizaje automático e inteligencia artificial para detectar cuentas que potencialmente participan en interacciones inapropiadas con menores». Cuando se le preguntó qué acciones toma Facebook cuando se descubre que alguien es un delincuente reincidente en el contenido de CSAM, Nain dijo que deben eliminar la cuenta de la persona.

Además, Facebook dice que eliminará los perfiles, páginas, grupos y cuentas de Instagram que se dedican a compartir imágenes de niños que de otro modo serían inocentes, pero que usan leyendas, hashtags o comentarios que contienen signos inapropiados de afecto o comentarios sobre los niños en la imagen.

Admite que encontrar contenido CSAM que no sea claramente “explícito y no represente desnudez infantil” es difícil y que necesita apoyarse en el texto que lo acompaña para ayudar a determinar mejor si el contenido sexualiza a los niños.

Facebook también ha agregado la opción de elegir «involucra a un niño» al informar una imagen en la categoría «Desnudez y actividad sexual». Dijo que estos informes serán priorizados para su revisión. También ha comenzado a utilizar la API de seguridad de contenido de Google para ayudarlo a priorizar mejor el contenido que puede contener explotación infantil para que lo evalúen nuestros revisores de contenido.

Con respecto a las imágenes íntimas compartidas sin consentimiento o lo que en el lenguaje común se conoce como ‘pornografía de la venganza’, Nain dijo que las políticas de Facebook no solo prohíben compartir fotos y videos, sino que también está prohibido hacer amenazas para compartir dicho contenido. Añadió que Facebook iría tan lejos como para desactivar la cuenta del abusador también.

“También hemos comenzado a utilizar tecnologías de comparación de fotografías en este espacio. Si ve una imagen íntima que se comparte sin el consentimiento de alguien en nuestra plataforma y nos lo informa, revisaremos ese contenido y determinaremos que sí, esta es una imagen íntima compartida no consensuada, y luego se agregará un hash a la foto, que es una huella digital. Esto evitará que cualquiera pueda volver a compartirlo en nuestras plataformas ”, explicó.

Facebook también dijo que está utilizando inteligencia artificial y aprendizaje automático para poder detectar dicho contenido, dado que las víctimas se quejaron de que muchas veces el contenido comparte lugares que no son públicos, como grupos privados o el perfil de otra persona.